Filtrování produktů na stránkách kategorií je ve světě SEO dlouhodobě diskutované téma a většina e-shopů ho nemá vyřešeno správně (resp. optimálně). Přitom jde o velmi důležitý prvek na webu, protože jeho optimální navržení po technické stránce rozhoduje o tom, zda budou vyhledávače tyto stránky generované na základě filtrů zobrazovat ve výsledcích vyhledávání nebo ne.

Navíc jde o stránky pro e-shop klíčové, protože typický návštěvník takové stránky přijde z vyhledávače prostřednictvím velmi specifického, často přímo prodejního dotazu. Při špatně navržené filtraci e-shop o tyto návštěvníky zbytečně přichází.

Navrhnout filtraci co nejoptimálněji je dřina a řešení je vždy potřeba přizpůsobit danému projektu. Přesto můžeme určit několik obecných bodů, které mohou být všem projektům společné a jejich dodržení je takovým nejnutnějším základem pro využití potenciálu zmíněných výhod.

Jaké základní vlastnosti by měly filtry mít?

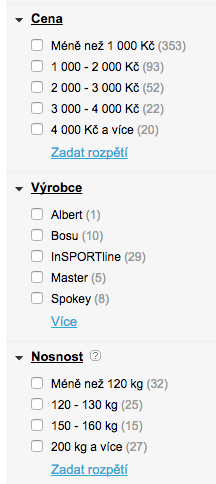

1. Hodnoty filtrů je vhodné udělat v podobě zaškrtávacích boxů – to je výhodné i z důvodu, pokud budete chtít uživatelům nabídnout možnost výběrů více hodnot od jednoho filtru.

2. Každá hodnota filtru má na sobě navázán klasický html odkaz a vede na jedinečnou url. I když vyhledávač Google umí už řádku let dobře pracovat s Java Scriptem, není vždy pravidlem, že s ním na vašem webu bude pracovat správně. Navíc tu máme vyhledávač Seznam.cz, kde je výsledek úplně nejistý.

3. Hodnoty filtrů se načítají podle aktuální dostupnosti v databázi, tedy na základě produktů, které jsou skutečně na webu pro daný filtr k dispozici. To je výhodné z několika důvodů:

- Uživatel ihned vidí, kolik produktů je pro daný filtr k dispozici.

- Uživatel se nemůže dostat přes filtry na stránku, kde nebude žádný produkt – proč někomu nabízet prázdnou stránku, kde je v lepším případě jen informace o tom, že produktu není k dispozici, a že je na výběr nějaký podobný…?

- Roboti vyhledávačů nebudou procházet tuny zbytečných kombinací filtrů, které reálně dlouhodobě nenabízí žádný obsah, což souvisí s optimalizací tzv. crawl budget.

4. Různé pořadí kombinací filtrů musí vždy vygenerovat stejnou url adresu. Jinými slovy, pokud si zvolím na e-shopu se zážitky nejprve dárky pro muže a potom výpis zážitků omezím pouze na region Praha, musí mi filtr vygenerovat stejnou url, jako v případě, že si nejprve omezím výběr na zážitky v Praze a potom pouze ty, co jsou pro muže.

Které filtry indexovat, a které ne?

Především bychom měli přemýšlet o tom, které stránky vůbec nechat roboty procházet, a to hlavně z důvodů zmíněného objemu crawl budget. Naším cílem by totiž mělo být optimalizovat cesty robotů napříč webem tak, aby procházely zejména pro nás významné stránky, nikoliv všechny stránky webu.

Nepotřebujeme si crawl budget „vyplýtvat“ na stránkách, které pro nás nemají reálný přínos. Procházení stovek tisíců nepotřebných kombinací filtrů může také značně zatěžovat server, a serverová odezva má zpětně vliv na velikost přiděleného crawl budget.

Jak zakázat procházení nepotřebných kombinací filtrů?

Ideálně pomocí souboru robots.txt, který je pro tyto účely určen. Jednoduše si definujeme pravidlo, které pokryje pro nás nepotřebné kombinace filtrů (pomocí analýzy klíčových slov a dat z Google Analytics zjistíme, které stránky nepotřebujeme, aby vyhledávače nabízely ve výsledcích hledání).

V případě parametru v url použijeme k vyloučení tento parametr a řádek v robots.txt může vypadat např.:

Disallow: /*cena=

Tím vyloučíme procházení všech url obsahující parametr cena.

Obdobně nezapomínejme zakázat i procházení vícenásobných filtrů!